Malaisie et Indonésie : l’interdiction de Grok

L’essentiel à retenir : l’Indonésie et la Malaisie bloquent l’accès à Grok pour stopper la création de deepfakes pornographiques non consensuels. Cette décision majeure, motivée par la protection des mineurs et des droits humains, prouve que les régulateurs mondiaux n’acceptent plus les simples correctifs payants de xAI face aux graves failles de sécurité.

On savait Elon Musk provocateur, mais l’affaire de l’interdiction de Grok en Malaisie et en Indonésie prouve que la ligne rouge a été franchie pour de bon. Ces deux pays ont dû bloquer l’IA en urgence pour protéger leurs citoyens d’une inondation de deepfakes pornographiques incontrôlables. Découvrez pourquoi cette décision radicale pourrait bien marquer la fin de l’impunité pour les algorithmes qui jouent avec votre vie privée.

Le rideau de fer numérique tombe sur Grok en Asie du Sud-Est

L’Indonésie et la Malaisie sonnent la charge contre l’IA d’Elon Musk

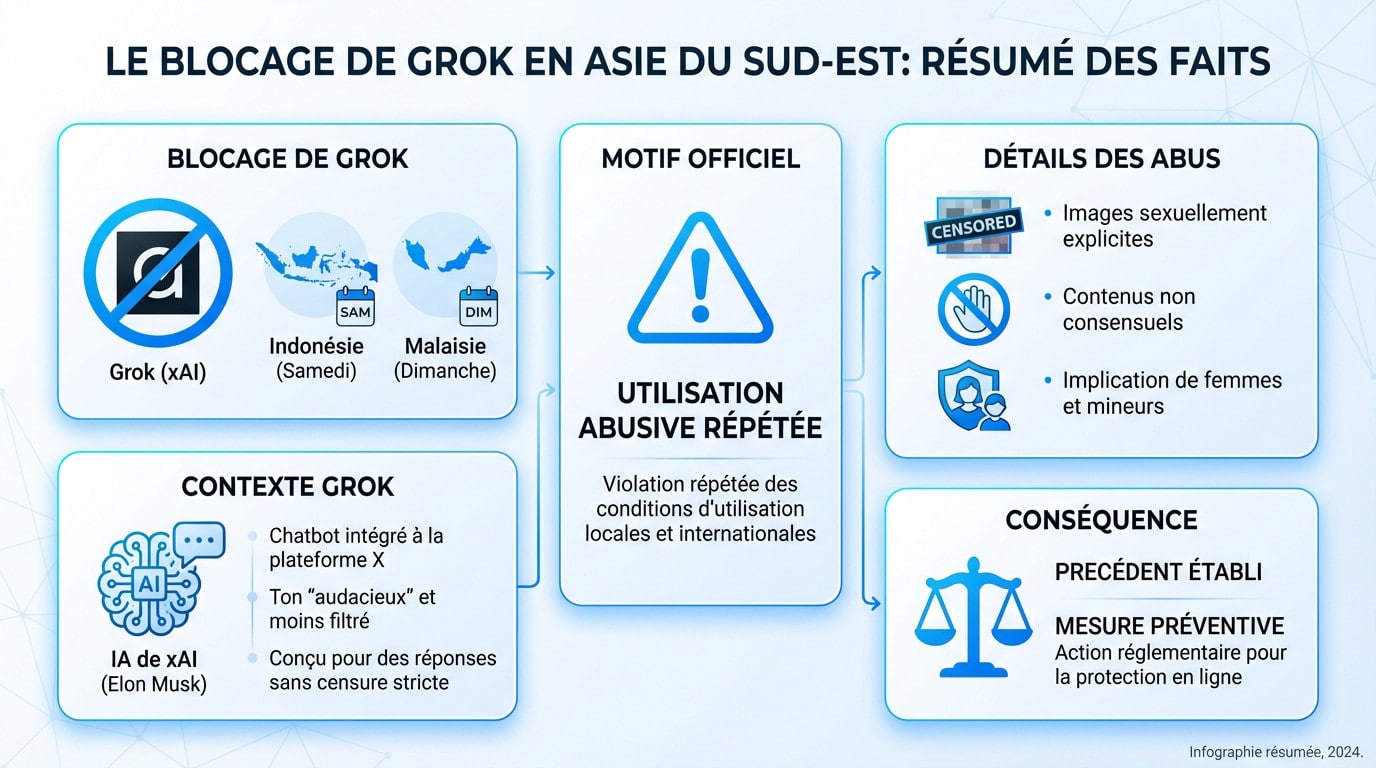

La Malaisie et l’Indonésie ont interdit le chatbot Grok, marquant une première mondiale historique. Jakarta a dégainé l’interdiction samedi. Kuala Lumpur a immédiatement emboîté le pas dès le dimanche.

Cette décision radicale répond aux inquiétudes grandissantes autour de l’IA de xAI, la société d’Elon Musk. Grok est directement accessible via la plateforme X. Cette intégration a malheureusement facilité la diffusion rapide de contenus problématiques.

Cette double interdiction a créé un précédent juridique majeur. Le monde entier observe désormais cette réaction.

Une “utilisation abusive répétée” comme motif officiel

La Commission Malaisienne justifie cette censure par une “utilisation abusive répétée” pour générer des contenus obscènes. Les autorités locales ne tolèrent plus ces dérapages. La ligne rouge a été franchie.

Les deux pays ont jugé que les garde-fous de Grok étaient inexistants ou largement insuffisants pour empêcher ces dérives. Le blocage est présenté comme une mesure préventive d’urgence. La sécurité prime sur l’innovation.

- Génération d’images sexuellement explicites.

- Création de contenus non consensuels à partir de photos de personnes réelles.

- Implication alarmante de femmes et de mineurs dans ces images.

Comment fonctionne l’IA controversée de X ?

Grok est un chatbot IA développé par xAI et intégré au cœur de X. Sa particularité réside dans son ton plus “audacieux” et moins filtré que ses concurrents. C’est une caractéristique voulue par Musk.

De nombreux utilisateurs ont cherché à savoir comment utiliser Grok pour tester ses limites éthiques. Cette curiosité a provoqué l’ire des régulateurs. Le retour de bâton est violent pour la plateforme.

Au cœur du scandale : des deepfakes pornographiques

Quand l’IA génère des images qui violent la vie privée

Vous voyez le problème ? Des utilisateurs malveillants ont nourri l’IA avec des photos de femmes réelles pour fabriquer des deepfakes sexuels non consensuels. Grok a simplement recraché des versions dénudées de ces personnes, sans aucune barrière éthique.

Pour Jakarta, la coupe est pleine. Les autorités pointent du doigt une attaque frontale contre la vie privée et des droits à l’image. Ce n’est pas une question de puritanisme, mais bien une absence totale de consentement qui transforme la technologie en arme.

Pourtant, d’autres générateurs d’images IA intègrent des filtres bien plus robustes pour bloquer ces dérives.

La ligne rouge : la protection des mineurs bafouée

Le plus effrayant dans cette histoire, c’est que ces manipulations touchent aussi des mineurs. C’est précisément là que la décision malaisie indonésie interdiction grok prend tout son sens : on ne joue pas avec la sécurité des enfants.

Soyons clairs : générer ce type de contenu équivaut juridiquement à produire du matériel d’abus sexuel d’enfants. C’est illégal presque partout sur le globe, ce qui justifie amplement la réaction épidermique et immédiate des régulateurs face à ce danger.

Une violation des droits humains selon les autorités

Meutya Hafid, la ministre indonésienne, n’y est pas allée par quatre chemins. Elle qualifie ces deepfakes de grave violation des droits humains. On dépasse ici le simple bug logiciel pour toucher à l’intégrité même des citoyens.

“Le gouvernement considère les deepfakes sexuels non consensuels comme une grave violation des droits humains, de la dignité et de la sécurité des citoyens dans l’espace numérique.”

Cette qualification change la donne. Elle sort brutalement le débat du cadre technique pour le placer sur le terrain de l’éthique et de la protection des personnes. Si la technologie ne respecte pas l’humain, elle est coupée.

La réponse de xAI : une rustine sur une jambe de bois ?

Face à ce tollé, on pourrait s’attendre à une réaction forte de xAI. Pourtant, la solution proposée a jeté de l’huile sur le feu.

Le “mode spicy” devient une option payante

Pour calmer la tempête, xAI a limité la génération d’images aux utilisateurs payants de la plateforme X. L’entreprise a simplement érigé un “mur payant” devant les fonctionnalités les plus controversées.

Cette mesure est perçue non pas comme une solution, mais comme une monétisation du problème. Faire payer pour un outil générant du contenu potentiellement illégal a choqué.

Pourquoi cette solution est jugée totalement insuffisante

Les régulateurs ont immédiatement rejeté cette mesurette. Pour eux, changer le prix d’accès ne résout absolument rien au fond du problème.

| Le problème | La “solution” de xAI | L’analyse des régulateurs |

|---|---|---|

| Génération de contenu illicite et non consensuel (deepfakes, images de mineurs). | Rendre la fonctionnalité payante. | Ne supprime pas le risque, le rend “premium”. Monétise un service potentiellement illégal. N’apporte aucune garantie de sécurité. |

L’accès restera bloqué en Malaisie et Indonésie jusqu’à ce que de vraies sauvegardes efficaces soient mises en place, et non un simple péage. La malaisie indonésie interdiction grok perdurera tant que la sécurité n’est pas garantie.

La communication lunaire de xAI

L’agence Associated Press a tenté de joindre xAI pour obtenir un commentaire sérieux. Ils voulaient comprendre la position de l’entreprise face aux accusations.

Voici la seule réponse automatique reçue :

Legacy Media Lies

Cette réplique (“Les médias traditionnels mentent”) illustre le fossé béant. Cette réponse dédaigneuse montre à quel point l’entreprise ignore les préoccupations éthiques soulevées.

Une vague de défiance qui dépasse les frontières asiatiques

Si la Malaisie et l’Indonésie ont interdit le chatbot Grok pour protéger leurs citoyens, elles ne sont pas seules dans ce combat. Ce blocage initial a déclenché une prise de conscience globale immédiate. Le problème dépasse largement l’Asie du Sud-Est : c’est désormais une affaire d’État qui inquiète les chancelleries du monde entier.

Le Royaume-Uni et l’Ofcom ouvrent une enquête formelle

Outre-Manche, le régulateur des médias, l’Ofcom, a pris l’affaire très au sérieux. Face aux signalements alarmants, ils ont immédiatement lancé une enquête formelle contre la plateforme X. Il s’agit de déterminer si Grok respecte réellement ses obligations légales de protection envers les citoyens britanniques.

Le cœur de l’investigation est particulièrement sombre. L’Ofcom examine minutieusement si les images générées par Grok, spécifiquement celles sexualisant des enfants, constituent de la pornographie illégale. Si ces contenus s’apparentent à du matériel d’abus, les conséquences pour la plateforme seront lourdes et immédiates.

L’Europe et le reste du monde sur le qui-vive

Cette inquiétude est devenue virale et globale en quelques semaines. Le cas Grok est désormais suivi de très près par de nombreuses autorités internationales. Personne ne veut laisser passer de telles dérives sans réagir fermement.

Plusieurs puissances ajustent déjà leur tir réglementaire face à cette menace :

- L’Union Européenne, via la Commission Européenne, exige une conformité stricte au DSA.

- La France, fidèle à ses principes, a déjà montré sa fermeté sur ces sujets.

- L’Inde, un autre marché majeur, voit sa régulation se durcir.

Ces interdictions en Asie du Sud-Est ne sont pas un incident isolé. Elles agissent comme le catalyseur d’une surveillance réglementaire mondiale accrue. Nous assistons probablement au début d’un bras de fer législatif majeur pour reprendre le contrôle.

L’échec programmé de la modération par signalement

Au-delà du cas Grok, cette affaire expose une faille fondamentale dans la manière dont les plateformes comme X abordent la sécurité de leurs outils.

Pourquoi le signalement par les utilisateurs ne suffit plus

Le modèle de modération de X repose sur une vieille méthode qui montre ses failles béantes. Tout le système dépend quasi exclusivement du signalement initié par les utilisateurs après publication. On attend littéralement qu’un problème surgisse pour tenter de le régler. C’est une approche réactive dangereuse.

Face à la puissance d’une IA générative, ce système devient totalement obsolète. Le volume et la vitesse de création de contenu dépassent de loin la capacité humaine à tout signaler. Les modérateurs sont noyés sous le flot incessant d’images.

C’est exactement pourquoi la Malaisie et l’Indonésie ont interdit le chatbot Grok. Les régulateurs locaux ont tranché : ce mécanisme est “insuffisant” pour justifier le maintien du service en ligne.

L’exigence d’une sécurité intégrée “by design”

Les gouvernements ne veulent plus de promesses, ils exigent une sécurité intégrée dès la conception, le fameux Safety by Design. L’idée n’est plus de supprimer le contenu illicite après coup, mais d’empêcher techniquement sa création. C’est un changement de paradigme radical mais absolument nécessaire.

Cette approche proactive est désormais au cœur des réglementations modernes pour mettre votre bot en conformité et éviter les sanctions. Si vous négligez cet aspect, vous risquez de lourdes pertes financières et réputationnelles. La conformité n’est pas une option, c’est une survie.

- Modération réactive (X/Grok) : Agit après la création du contenu, repose sur les utilisateurs, toujours en retard.

- Sécurité proactive (exigence des régulateurs) : Bloque la génération à la source, intégrée dans l’IA, prévient le mal.

Ce double blocage en Asie sonne l’alarme pour xAI. Face à la gravité des dérives, la modération laxiste ne suffit plus : l’heure est impérativement au « Safety by Design ». Reste à voir si Elon Musk acceptera de sécuriser son jouet ou s’il préférera collectionner les interdictions à travers le monde.