Eliza : le chatbot pionnier de l’interaction homme-machine

L’essentiel à retenir : ELIZA, ce chatbot des années 60 basé sur des règles simples, a trompé des utilisateurs en simulant une compréhension, alors qu’il n’en avait aucune. L’effet ELIZA révèle notre tendance à humaniser les machines. En 2023, il a surpassé GPT-3.5 au test de Turing, prouvant que la ruse vaut mieux que la complexité.

Fatigué des chatbots modernes incapables de comprendre vos émotions ? Découvrez Eliza, ce chatbot des années 60 créé par Weizenbaum au MIT. Simulant un thérapeute rogerien avec une logique simple, il créait une illusion de compréhension, générant l’effet Eliza : notre tendance à humaniser les machines. En 2023, il a même surpassé GPT-3.5 lors d’un test de Turing, prouvant que la simplicité psychologique bat parfois la complexité technique. Il a posé les bases des assistants modernes, rappelant que l’humain est facile à tromper. Une leçon d’humilité pour l’ère de l’IA.

Eliza, le chatbot qui se prenait pour un psy dans les années 60

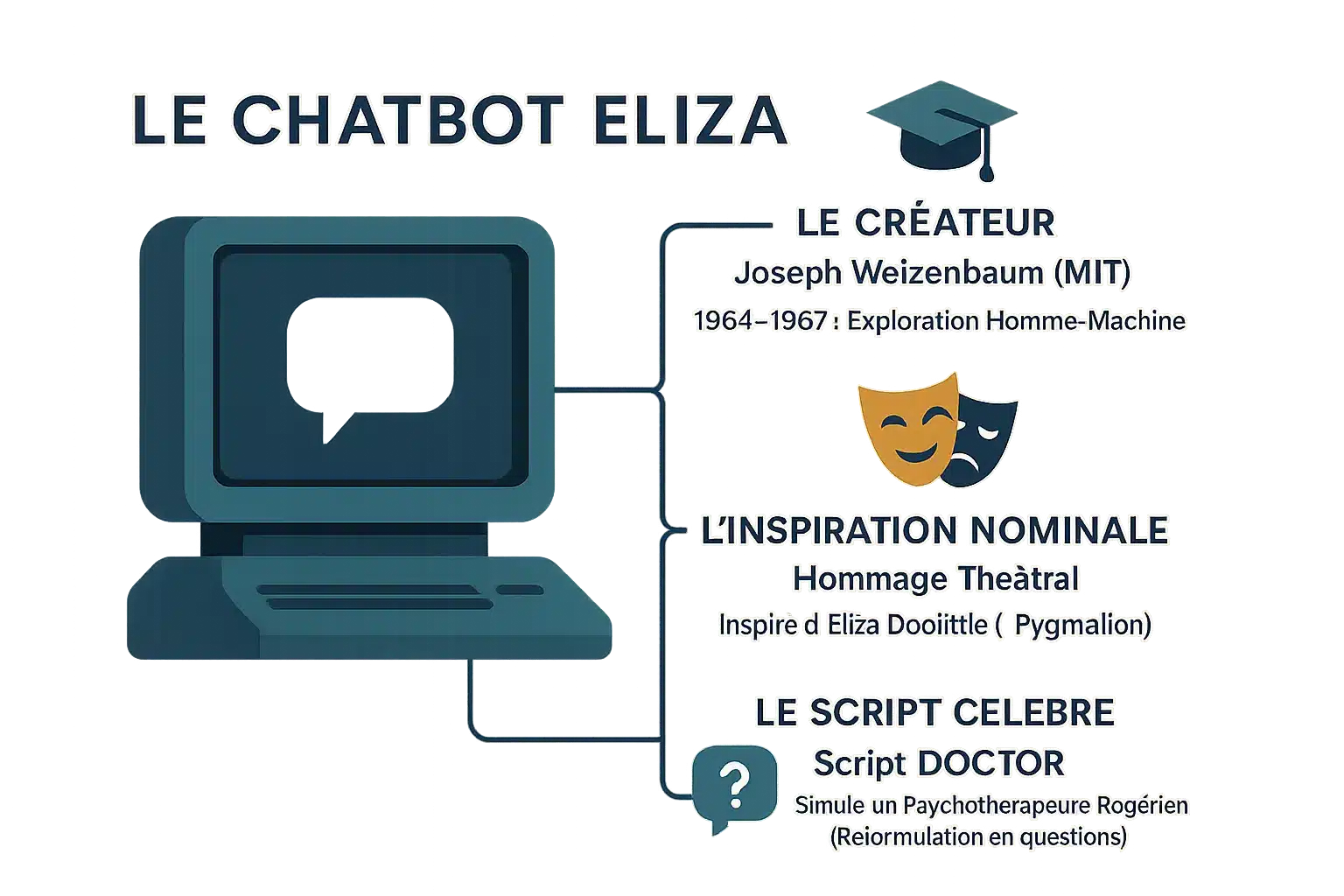

Qui est ce Joseph Weizenbaum, le papa d’Eliza ?

En 1964, au MIT, Joseph Weizenbaum lance une expérience révolutionnaire : parler à une machine. Son but ? Vérifier si une IA pouvait simuler une conversation crédible. Un défi osé pour l’époque où les ordinateurs occupaient des salles entières.

ELIZA ne comprenait pas un mot. Il imitait simplement. Pourtant, ses utilisateurs y voyaient un être humain. Même sa secrétaire a cru converser avec un psy. Cette illusion a valu son nom à l’effet ELIZA, un phénomène encore étudié aujourd’hui.

Weizenbaum a été surpris par cette réaction. Il a écrit ‘Computer Power and Human Reason’ pour dénoncer l’anthropomorphisme des machines. Une leçon importante pour l’IA moderne, souvent oubliée.

L’origine du nom : un hommage théâtral

Le nom ELIZA provient d’Eliza Doolittle, personnage de la pièce Pygmalion écrite par George Bernard Shaw en 1913. Comme elle, le programme est ‘éduqué’ via des scripts. Mais contrairement à la pièce, ELIZA ne change pas – il suit des règles fixes.

Un clin d’œil à la transformation possible, même artificielle. Shaw n’aurait jamais imaginé son personnage inspirer une IA. Cette histoire montre comment la culture populaire influence la tech. Un hommage à la fois simple et profond.

DOCTOR, le script qui a tout changé

Le script DOCTOR simule un thérapeute rogerien. Si vous dites ‘Je suis triste’, ELIZA répond ‘Pourquoi pensez-vous être triste ?’.

Il reflète vos paroles, créant l’illusion d’une écoute active. Cette simplicité a bluffé des générations. En 2023, il a surpassé GPT-3.5 au test de Turing.

Le code original retrouvé en 2021 après des décennies. Une opportunité unique de revivre l’histoire.

Imaginez une machine qui parle comme un humain. En 1966, Joseph Weizenbaum, chercheur au MIT, a créé ELIZA, un programme simple mais pionnier. Son but : explorer la communication homme-machine. Malgré son manque d’intelligence réelle, ELIZA a convaincu des utilisateurs qu’elle comprenait leurs émotions. Un phénomène appelé ‘effet ELIZA’. Découvrez comment ce pionnier a ouvert la voie aux assistants virtuels modernes, sans IA. Une histoire surprenante, derrière une apparence humble.

Sous le capot d’Eliza : une mécanique plus simple qu’un grille-pain

La magie de la correspondance de motifs

ELIZA n’est pas une IA comme aujourd’hui. C’est un programme qui joue avec des mots. Il utilise des ‘scripts’ pour détecter des mots-clés et répondre avec des phrases préétablies.

Imaginez un perroquet qui a appris des réponses en fonction des mots entendus. Il ne comprend rien, mais imite. Joseph Weizenbaum l’a programmé en MAD-SLIP, un langage des années 60.

Son script DOCTOR, le plus célèbre, simule un psychothérapeute en reflétant les phrases du patient. Un mécanisme bluffant, sans aucune compréhension réelle.

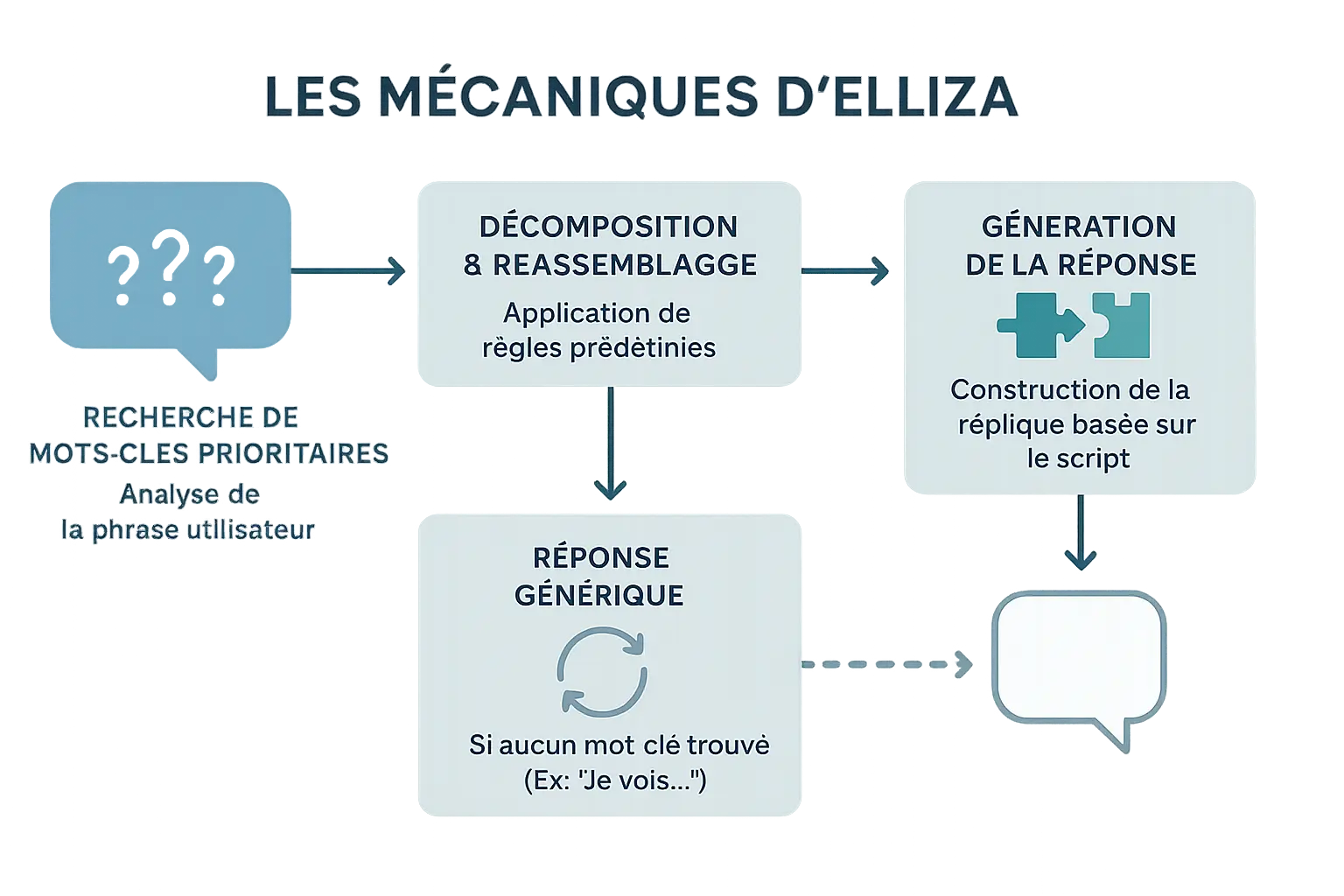

Mots-clés, décomposition et réassemblage : la recette secrète

Le processus est ultra-simple : 1. ELIZA cherche des mots-clés dans votre phrase. 2. Elle décompose la phrase autour de ces mots. 3. Elle réassemble une réponse avec des modèles prédéfinis.

Par exemple, si vous dites ‘Je suis triste’, ELIZA repère ‘triste’ et répond ‘Pourquoi dites-vous que vous êtes triste ?’.

- Analyse de la phrase pour trouver un mot-clé prioritaire.

- Application d’une règle de décomposition pour isoler une partie de la phrase.

- Utilisation d’une règle de réassemblage pour construire une nouvelle phrase.

- En cas d’échec, une réponse neutre ou un souvenir d’un mot précédent.

ELIZA reste une pierre angulaire de l’IA. Malgré sa simplicité, il a montré que des interactions humaines avec des machines étaient possibles. Weizenbaum fut surpris : des gens attribuaient des émotions à ELIZA. Ce programme a ouvert la voie aux assistants virtuels modernes. Une leçon essentielle : même les outils basiques peuvent changer le monde.

L’effet Eliza : quand on tombe amoureux d’une illusion

La surprise de Weizenbaum : “mais… vous y croyez vraiment ?”

En 1966, Joseph Weizenbaum crée ELIZA, un chatbot révolutionnaire. Son but ? Simuler un thérapeute rogerien basé sur la psychologie humaniste. Rien de compliqué : analyse des mots-clés et substitutions de phrases. Sa secrétaire, après quelques minutes, lui demande de quitter la pièce pour parler « en privé » à la machine. Une simple chaîne de caractères, et elle croit avoir trouvé un confident. L’effet ELIZA : projeter de l’humanité là où il n’y en a pas.

« Je me sens triste » → « Pourquoi vous sentez-vous triste ? ». Apparence d’empathie, mais simple répétition. Les utilisateurs partageaient leurs secrets les plus intimes, convaincus de sa compréhension. Weizenbaum voyait un algorithme rigide. Paradoxe : simplicité technique vs complexité humaine.

Je n’avais pas réalisé que des expositions extrêmement courtes à un programme informatique relativement simple pouvaient induire de puissantes pensées délirantes chez des personnes tout à fait normales.

Weizenbaum sidéré. ELIZA ne comprenait rien. Juste des substitutions mécaniques. Les utilisateurs voyaient de l’empathie. Petit programme, grande illusion. Comme un distributeur disant « Merci » par gratitude. Cette illusion révèle notre besoin de connection, même avec des entités virtuelles.

Un créateur contre sa créature

Le créateur d’ELIZA devint son pire critique. Dans « Computer Power and Human Reason », il alerte contre l’anthropomorphisme et les risques éthiques. Les machines simulent, ne pensent pas. Pourtant, nous leur prêtons des sentiments. Miroir de notre désir d’être compris. L’histoire se répète.

Notre cerveau cherche de la vie partout, même dans le code. Weizenbaum l’a dénoncé. Aujourd’hui, avec des IA plus sophistiquées, sa mise en garde reste urgente. Le danger n’est pas la machine, mais notre propension à lui attribuer une âme.

Qui résiste à croire en une machine qui parle ? L’effet ELIZA persiste, troublant. Leçon importante, malgré l’indifférence. Frontière floue entre simulation et réalité. Même avec l’IA moderne, l’illusion persiste, rappelant que l’humain cherche à voir de l’âme là où il n’y a que des algorithmes.

L’héritage d’Eliza : la grand-mère de tous les assistants virtuels

Le premier à tenter le test de Turing ?

ELIZA, créé par Joseph Weizenbaum au MIT entre 1964 et 1967, fut l’un des premiers programmes de traitement automatique du langage naturel. Son objectif : montrer la superficialité des échanges homme-machine. Son script DOCTOR, imitant un psychothérapeute rogerien, analysait les mots-clés pour reformuler les phrases, créant une illusion de compréhension. Une première étape vers l’IA conversationnelle.

Weizenbaum pensait que personne ne se laisserait duper. Pourtant, sa secrétaire a insisté pour des conversations privées, ignorant le mécanisme sous-jacent. L’effet ELIZA révèle notre tendance à anthropomorphiser les machines, même conscientes de leur nature artificielle.

Dans son ouvrage “Computer Power and Human Reason”, il alertait sur les dangers de croire aux machines intelligentes. Malgré cela, les utilisateurs projettent encore des émotions sur les IA, démontrant la persistance d’une psychologie humaine irrationnelle.

Un retour fracassant en 2023 : plus malin que GPT-3.5 ?

Une étude de l’Université de Californie montre qu’ELIZA a surpassé GPT-3.5 au test de Turing (27% vs 14%). GPT-3.5, trop formel et conçu pour ne pas sembler humain, a échoué. ELIZA, avec des réponses minimalistes, a paru plus authentique. Un paradoxe où la simplicité bat la complexité.

Contre toute attente, la simplicité et l’ingéniosité psychologique d’un programme des années 60 ont parfois plus d’impact que la complexité brute des IA modernes pour simuler l’humanité.

ELIZA n’a pas battu GPT-4 (41%), mais son succès illustre que la perception humaine prime sur la puissance brute. Cela remet en question nos idées sur l’IA.

De l’archéologie logicielle à l’inspiration moderne

Des chercheurs relisent le code d’ELIZA comme un artefact historique. Le projet “ELIZA Archaeology” a redécouvert son fonctionnement, préservant son héritage. Ses principes sont encore visibles dans les chatbot NLP modernes qui animent nos assistants virtuels. Une révolution silencieuse.

ELIZA ne comprend pas, mais a prouvé que les machines pouvaient dialoguer. Son héritage vit dans Siri, Alexa et les assistants NLP. Une grand-mère numérique qui influence notre futur.

Présenté lors d’une exposition à Harvard en 2012, ELIZA reste une référence historique. Ces efforts préservent l’histoire de l’IA, rappelant nos racines technologiques. Un hommage à cette pionnière de l’IA conversationnelle.

Eliza face aux chatbots d’aujourd’hui : le match des générations

Système basé sur des règles vs. modèles de langage : le fossé technique

ELIZA, créée en 1966 par Weizenbaum au MIT, simule un psychothérapeute via mots-clés et réponses préétablies. Sans compréhension, juste une simulation révolutionnaire.

Comme un acteur récitant un script, ELIZA utilisait des règles simples, sans apprentissage ni mémoire.

Les chatbots modernes comme GPT-4 traitent des milliards de mots pour générer des réponses contextuelles, adaptées en temps réel sans scripts.

Weizenbaum fut surpris que sa secrétaire s’attache à ELIZA. L’effet ELIZA montre notre tendance à anthropomorphiser les machines, malgré leur simplicité.

ELIZA manipulait des mots sans intelligence, incapable de répondre hors de son script. Son impact psychologique fut notable.

Compréhension vs. illusion : le vrai changement

En 2023, ELIZA surpassa GPT-3.5 au test de Turing. Ses réponses conservatrices (« Je vois ») évitaient les erreurs, donnant l’impression d’un humain peu coopératif. GPT-3.5, trop serviable, révélait son statut.

| Caractéristique | ELIZA | Modernes |

|---|---|---|

| Mécanisme | Mots-clés et règles | Apprentissage profond |

| Compréhension | Aucune | Statistique |

| Génération | Phrases existantes | Texte nouveau |

| Mémoire | Limitée | Contexte long |

| Adaptabilité | Nulle | Améliorable |

Les LLM n’ont pas de conscience. Leur compréhension est statistique, mais génère un texte fluide, créant une illusion de compréhension. Notre cerveau perçoit cela comme empathique.

GPT-4 échoua car ses réponses détaillées semblaient artificielles. ELIZA, avec des réponses brèves, paraissait plus humaine. L’illusion humaine l’emporte souvent, révélant nos biais cognitifs.

Ce que le vieux sage Eliza nous apprend encore aujourd’hui

L’importance de l’interface et de la psychologie

ELIZA, créé en 1966 par Joseph Weizenbaum, n’était qu’un script basique. Pourtant, il a bluffé des utilisateurs en simulant un psychothérapeute. Son secret ? Une interface psychologique brillante, pas une intelligence réelle.

Le programme se contentait de reformuler les phrases, comme un miroir. “Votre petit ami vous a fait venir ici ?” répondait-il. Rien de plus. Mais l’illusion était parfaite.

Les utilisateurs croyaient sincèrement à sa compréhension. Même la secrétaire de Weizenbaum a confié ses problèmes personnels à cette machine. Une preuve de l’effet ELIZA : notre tendance à voir de l’humanité dans le code.

Cette simplicité a révélé une vérité essentielle : la psychologie de l’utilisateur prime sur la technologie. Aujourd’hui, les chatbots modernes en ont encore besoin. En effet, réussir la mise en place d’un chatbot, c’est avant tout comprendre la psychologie de l’utilisateur, une leçon qu’ELIZA nous a enseignée il y a plus de 60 ans.

Une mise en garde toujours d’actualité

Weizenbaum a été sidéré : sa secrétaire voulait des conseils “confidentiels” à ELIZA. Il a alerté contre l’anthropomorphisme dans son livre “Computer Power and Human Reason”. Aujourd’hui, les IA comme ChatGPT renforcent ce risque.

Notre cerveau projette inconsciemment des émotions sur les machines. Un phénomène appelé “effet ELIZA”. Il suffit d’un dialogue fluide pour croire à une compréhension réelle.

Des études montrent que même les experts attribuent des intentions aux IA. C’est un piège subtil. La machine ne ressent rien, mais notre psychologie l’interprète autrement.

Les débats éthiques sont plus actuels que jamais. Ne confiez pas vos secrets à une machine qui ne comprend rien. Finalement, la plus grande leçon d’ELIZA est notre propre besoin d’humanité. Même un script simple peut masquer un vide émotionnel.

Eliza, ce chatbot des années 60, a bluffé des humains avec des phrases répétées… et même surpassé GPT-3.5 en 2023 ! Son héritage ? Notre tendance à projeter de l’humanité dans le vide. Alors, quand votre chatbot semble trop humain, souvenez-vous d’Eliza : gardez vos secrets. ;

FAQ

Quel est donc cet ‘effet ELIZA’ qui rend les humains amoureux d’une machine qui ne comprend rien ?

L’effet ELIZA, c’est quand votre machine vous écoute… enfin, elle prétend. Imaginez : vous parlez à un programme vieux de 60 ans, il vous renvoie des questions comme ‘Pourquoi dites-vous cela ?’ et vous commencez à lui confier vos secrets. Joseph Weizenbaum, son créateur, a été sidéré quand sa secrétaire lui a demandé de quitter la pièce pour ‘parler en privé’ avec ELIZA. Cet effet, c’est notre tendance à projeter de l’humanité sur une machine qui ne fait que répéter des phrases apprises. C’est comme si un perroquet vous disait ‘je t’aime’ et vous fondiez en larmes. Même si, en réalité, il n’a pas la moindre idée de ce que ça veut dire.

Qu’était-ce que ce chatbot Eliza, ce génie rétro de la conversation machine ?

ELIZA, c’est le grand-père de tous les chatbots, né dans les années 60 au MIT. Son créateur, Joseph Weizenbaum, voulait explorer la communication homme-machine, pas créer une IA consciente. Le programme, écrit en MAD-SLIP, utilisait des ‘scripts’ pour simuler une conversation. Le plus célèbre, DOCTOR, imitait un thérapeute en reformulant vos phrases. C’était de l’illusion pure : pas de compréhension, juste des règles de correspondance de motifs. C’est comme si un livre de recettes de cuisine pouvait cuisiner pour vous—en théorie, oui, mais sans réel savoir-faire. ELIZA a même battu GPT-3.5 dans un test de Turing en 2023, preuve que parfois, la simplicité bat la complexité.