OpenEvidence : l’intelligence artificielle qui aide les médecins

Ce qu’il faut retenir : OpenEvidence se distingue des IA génératives classiques en s’appuyant exclusivement sur des sources médicales validées par les pairs pour éliminer les hallucinations. Ce copilote offre ainsi une sécurité indispensable pour la prise de décision clinique rapide. Une solution qui a déjà fait ses preuves en assistant plus de 100 millions de consultations aux États-Unis.

La peur de l’erreur médicale causée par les hallucinations des chatbots généralistes vous retient-elle d’intégrer la technologie au cabinet ? Cette évaluation openevidence intelligence artificielle détermine si ce copilote, nourri exclusivement aux publications validées du NEJM et du JAMA, constitue vraiment le filet de sécurité fiable dont vous avez besoin pour vos diagnostics critiques. Nous passons ici au crible ses performances réelles face aux géants du secteur ainsi que ses limites juridiques, car si l’outil s’annonce puissant, il ne remplacera jamais votre jugement clinique (ni votre café du matin).

OpenEvidence : un copilote IA pour médecins, pas un chatbot généraliste

Qu’est-ce que OpenEvidence exactement ?

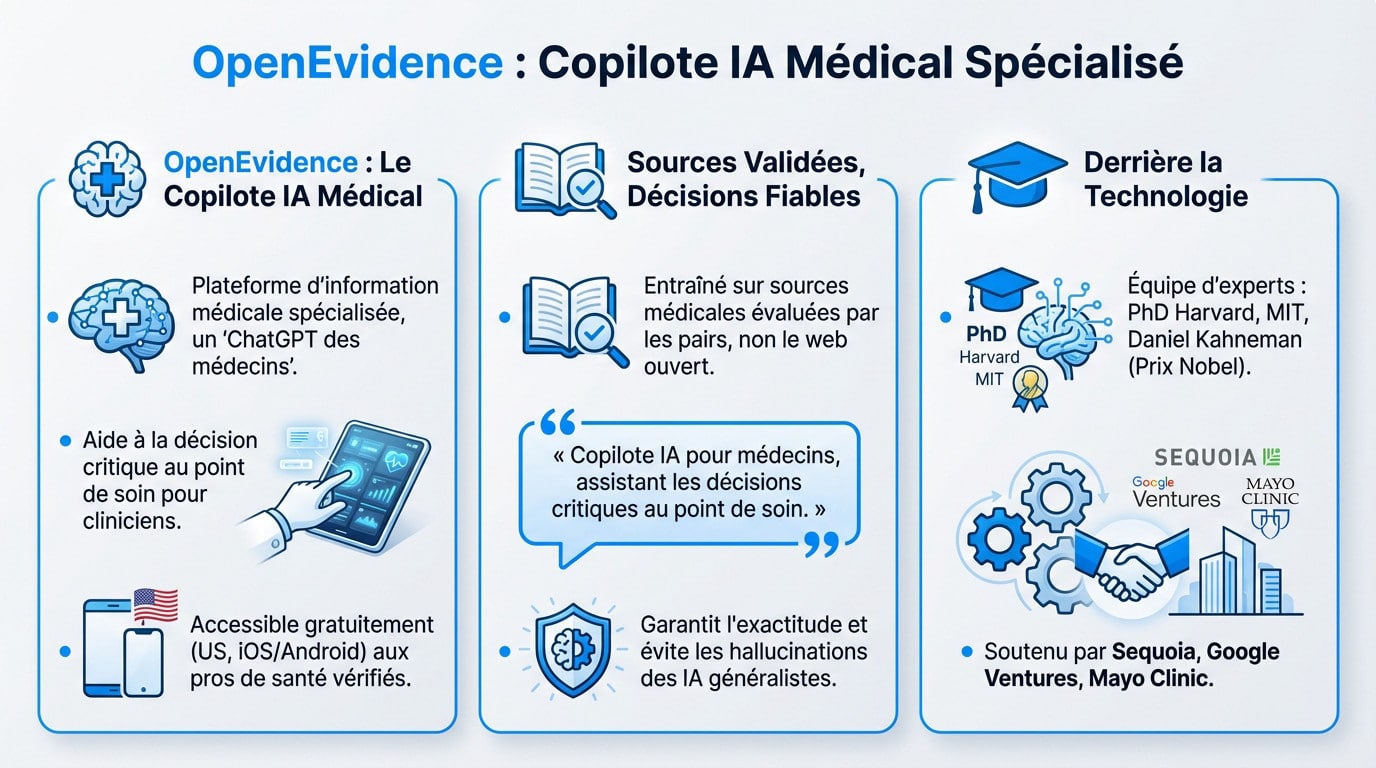

OpenEvidence n’est pas un simple chatbot, mais une plateforme d’information médicale spécialisée. Considérez-le comme le “ChatGPT des médecins”, un copilote IA conçu spécifiquement pour l’aide à la décision.

Son but est d’assister les cliniciens au point de soin pour des décisions critiques. Il vise concrètement à sauver des vies et à améliorer les soins aux patients en s’appuyant sur des données fiables. L’accès est gratuit pour les professionnels de santé américains vérifiés, sur iOS et Android.

La différence fondamentale : des sources validées par les pairs

Voici la différence majeure : OpenEvidence ne s’entraîne pas sur le web ouvert. Il utilise exclusivement des sources médicales évaluées et reconnues pour ses réponses.

OpenEvidence se présente comme un copilote IA pour les médecins, conçu pour les assister dans la prise de décisions critiques directement au point de soin.

Cette rigueur dans l’évaluation OpenEvidence intelligence artificielle garantit l’exactitude des faits. C’est indispensable pour éviter les hallucinations, un défaut récurrent qui décrédibilise souvent les IA généralistes.

Qui est derrière cette technologie ?

L’équipe est solide, composée de PhD et d’ingénieurs de Harvard et du MIT. On note même la collaboration de Daniel Kahneman, lauréat du prix Nobel.

De plus, la plateforme est soutenue par des investisseurs de premier plan comme Sequoia, Google Ventures et la Mayo Clinic, ce qui confirme sa crédibilité sur le marché.

L’évaluation sur le terrain : OpenEvidence face aux IA grand public

Maintenant qu’on a posé les bases, voyons concrètement ce que vaut cet outil face à ses concurrents bien connus du grand public.

Le benchmark : précision et fiabilité à l’épreuve

Pour mener une évaluation openevidence intelligence artificielle crédible, des tests comparatifs stricts ont été lancés. Des questions cliniques sur des protocoles précis ont été posées simultanément à OpenEvidence, ChatGPT et Gemini. L’objectif était de voir qui tient la route face à la complexité médicale.

Ces benchmarks visent à mesurer la performance réelle sur des dossiers médicaux authentiques. Ici, on ne cherche pas la conversation de salon, mais une précision factuelle chirurgicale. L’approximation n’a pas sa place au chevet du patient.

Cette exigence valide son positionnement d’outil spécialisé. C’est toute la différence entre un tchat et un expert.

Comparatif direct : pourquoi les sources changent tout

Ce tableau résume les divergences fondamentales qui séparent ces technologies. Vous saisirez immédiatement la valeur ajoutée pour un professionnel qui refuse de jouer à la roulette russe avec ses sources.

| Critère d’évaluation | OpenEvidence | IA Généralistes |

|---|---|---|

| Source des données | Publications médicales validées par les pairs (NEJM, JAMA), directives cliniques (NCCN). | Web ouvert, corpus de textes non vérifiés, livres, articles divers. |

| Précision & Hallucinations | Haute précision, risque d’hallucination très faible car basé sur des sources circonscrites. | Variable, risque élevé d’erreurs factuelles ou d’hallucinations (informations inventées). |

| Transparence des sources | Citations directes et liens vers les études et articles originaux pour chaque réponse. | Sources souvent opaques ou non citées, rendant la vérification difficile. |

| Cas d’usage principal | Aide à la décision clinique rapide, vérification de protocoles, recherche de preuves scientifiques. | Rédaction, résumé, conversation, tâches créatives et informationnelles générales. |

Ce tableau pose les bases, confirmées par ce comparatif complet des IA face à ChatGPT sur leurs forces respectives.

Adoption et crédibilité : OpenEvidence, déjà un standard aux États-Unis ?

Un outil séduisant sur le papier, c’est bien. Mais est-il vraiment utilisé sur le terrain ? Les chiffres tranchent le débat.

Une adoption massive par les cliniciens américains

Une évaluation openevidence intelligence artificielle révèle des chiffres fous. Plus de 100 millions de consultations cliniques assistées par l’IA ont déjà eu lieu. C’est colossal. C’est l’IA médicale la plus utilisée par les médecins américains vérifiés.

L’impact sur la santé publique est tout aussi vertigineux. Cette année, plus de 100 millions d’Américains seront soignés. L’échelle est immense.

On le décrit désormais comme le “système d’exploitation par défaut” du savoir médical aux USA. C’est devenu la norme.

Des partenariats qui assoient sa légitimité

La force de frappe d’OpenEvidence ne vient pas de nulle part. Ce n’est pas une simple startup isolée dans son coin. Elle s’appuie sur des alliances stratégiques solides.

Elle intègre directement les contenus et directives de géants du secteur :

- The New England Journal of Medicine (NEJM)

- JAMA et le JAMA Network

- National Comprehensive Cancer Network (NCCN)

Ajoutez à cela le soutien d’institutions comme la Mayo Clinic. La crédibilité est totale.

Un gain de temps concret au quotidien

Le bénéfice numéro un rapporté par les pros est le gain de temps. L’accès immédiat aux preuves libère l’esprit. On se focalise enfin sur le patient.

C’est toute la promesse de l’IA conversationnelle dans ce métier. L’automatisation de la recherche devient vitale.

Les zones de vigilance : ce qu’en pensent les médecins

La question de la responsabilité légale

On touche ici un point sensible qui fait trembler plus d’un confrère. Si l’IA se plante dans son diagnostic, qui porte le chapeau au tribunal ? Est-ce le développeur de la Silicon Valley ou le médecin qui a suivi la recommandation ? C’est un flou juridique total et inquiétant.

Face à ce risque, la prudence est mère de sûreté. C’est pourquoi :

L’outil est puissant, mais la responsabilité finale reste celle du clinicien. Une supervision humaine vigilante n’est pas une option, c’est une obligation déontologique.

La supervision humaine reste non négociable

Ne nous y trompons pas : OpenEvidence est un simple outil d’aide, jamais un remplaçant. Une évaluation openevidence intelligence artificielle sérieuse montre que le praticien doit toujours vérifier et valider l’information brute.

L’objectif n’est pas de suivre aveuglément les réponses générées, mais de les utiliser comme une base de recherche ultra-rapide pour gagner du temps. La décision finale et le contexte spécifique du patient priment toujours.

La gestion des biais et des cas complexes

Voici une autre limite concrète : une IA, aussi pointue soit-elle, galère souvent avec les cas atypiques ou les patients présentant de lourdes et multiples comorbidités.

Les données d’entraînement, même excellentes, ne sont que le reflet de populations générales. L’adaptation fine à l’individu reste, et restera, la prérogative du médecin.

Et en France ? Pertinence et défis d’OpenEvidence en Europe

Le mur des recommandations cliniques locales

C’est là que le bât blesse pour nous. OpenEvidence s’appuie sur des géants comme le NCCN, mais ce sont des sources américaines. Si vous cherchez les directives spécifiques de la Haute Autorité de Santé (HAS), vous risquez de faire chou blanc.

Pour un praticien européen, la prudence est donc de mise. Ne prenez pas tout pour argent comptant : il faut impérativement croiser ces réponses avec nos propres référentiels de soins locaux pour éviter toute déconvenue.

La conformité RGPD, un enjeu de taille

Côté sécu, ils sont blindés HIPAA aux USA, mais est-ce compatible avec notre RGPD ? Rien n’est moins sûr. Le flou artistique règne actuellement sur la conformité européenne de la plateforme.

Même si vous ne saisissez aucune info patient, l’outil aspire vos données d’utilisation. Sans transparence totale sur l’hébergement de ces métadonnées, c’est un risque juridique que beaucoup préfèrent éviter.

Les questions à se poser avant de l’adopter en Europe

Vous hésitez encore ? C’est normal. Voici les points bloquants à vérifier avant d’intégrer cette évaluation openevidence intelligence artificielle dans votre routine médicale.

- L’IA gère-t-elle correctement les spécificités des directives européennes ?

- La protection des données est-elle alignée avec les exigences du RGPD ?

- La pertinence des sources américaines est-elle suffisante pour ma pratique quotidienne en France ?

En bref, OpenEvidence redéfinit l’accès au savoir médical avec ses sources fiables. C’est un copilote puissant, mais qui ne dispense pas de surveiller les angles morts, surtout en Europe. Gardez le contrôle : le stéthoscope ne fait pas le diagnostic tout seul, et cette IA non plus !