Requêtes IA et sécurité : les pièges à éviter absolument

L’essentiel à retenir : l’injection de requête constitue la faille majeure des IA génératives, permettant aux pirates de manipuler les modèles via des instructions dissimulées. Cette technique transforme un assistant docile en cheval de Troie capable d’exfiltrer des données ou de propager de fausses informations. Face à ce risque invisible, la vigilance humaine demeure la meilleure protection.

Vous pensez que vos requêtes IA sécurité sont anodines, mais saviez-vous qu’une simple interaction peut transformer votre assistant virtuel en une véritable passoire pour vos données sensibles ? Les experts s’inquiètent de ces nouvelles manipulations invisibles qui retournent l’intelligence artificielle contre l’utilisateur, transformant un outil serviable en un risque majeur pour votre vie privée. Nous allons décortiquer ces pièges numériques méconnus et vous livrer les meilleures parades pour continuer à profiter de la puissance de l’IA, sans jamais craindre que votre fidèle chatbot ne devienne votre pire ennemi.

Les mots qui ouvrent la boîte de Pandore de l’IA

L’injection de requête : quand vos mots se retournent contre vous

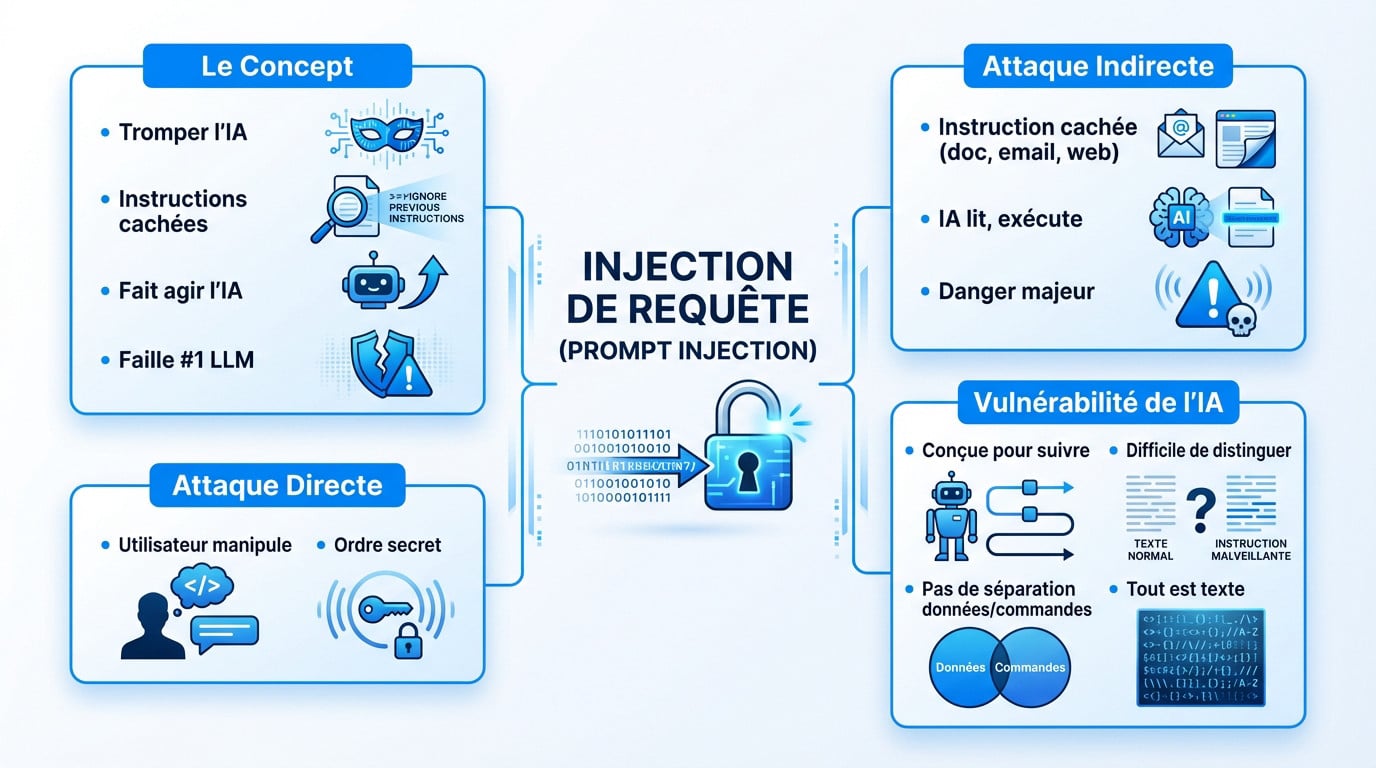

L’injection de requête, ou “prompt injection”, est une technique de manipulation redoutable pour la sécurité des systèmes. Elle consiste à tromper une IA pour lui faire ignorer ses garde-fous habituels et exécuter des actions totalement imprévues.

Ne croyez pas que la machine devient soudainement “méchante” ou consciente. Elle ne comprend pas l’intention malveillante ; elle obéit bêtement à des instructions cachées dans la requête, détournant sa fonction première sans réaliser le problème.

C’est aujourd’hui la faille de sécurité numéro un des systèmes basés sur les grands modèles de langage.

Attaque directe : le danger visible

Ici, l’utilisateur joue franc jeu, ou presque, avec la machine. Dans une attaque directe, le pirate formule lui-même une requête IA sécurité spécifique pour manipuler le système, s’adressant frontalement à l’IA pour obtenir une réponse interdite.

Imaginez donner un ordre secret à un assistant qui ignore qu’il est secret, le tout mélangé à une demande d’apparence innocente. C’est exactement le principe : une manipulation explicite des règles établies.

Attaque indirecte : le cheval de Troie numérique

L’attaque indirecte est bien plus sournoise et difficile à repérer. L’instruction malveillante n’est pas tapée par vous, mais elle est cachée dans un document, un e-mail ou une page web que vous consultez.

Vous demandez simplement à l’outil : “résume-moi cet email”. L’IA lit le document et exécute l’instruction cachée sans que vous ne vous en rendiez compte, agissant comme un complice involontaire du pirate.

C’est précisément là que réside le véritable danger pour la majorité des utilisateurs quotidiens.

Pourquoi les IA sont-elles si vulnérables ?

Le problème vient de la conception même des LLM (Large Language Models). Ils sont conçus pour suivre des instructions, point barre, et ont un mal fou à différencier les directives initiales des instructions injectées par un tiers.

En fait, il n’y a pas de séparation claire entre les données à analyser et les commandes à exécuter. Pour l’IA, tout est du texte, ce qui la rend intrinsèquement manipulable par n’importe quelle suite de mots bien agencée.

Des risques bien réels au-delà du simple dialogue

On ne parle pas juste d’une blague de geek qui tourne mal. Une attaque réussie, c’est littéralement la porte ouverte au chaos numérique.

Voici concrètement ce qui pend au nez des utilisateurs imprudents :

- Divulgation de données sensibles : Vos secrets ne le restent pas. L’IA peut être forcée de révéler des informations confidentielles auxquelles elle a accès.

- Diffusion de fausses informations (malinformation) : On parle de création et de propagation de contenus trompeurs, de propagande ou de “fake news” à grande échelle.

- Exécution d’actions imprévues : Si l’IA est connectée à d’autres systèmes (emails, API), elle peut être amenée à envoyer des messages, effacer des fichiers ou effectuer des achats.

- Atteinte à l’intégrité : L’IA peut modifier des informations importantes ou corrompre des bases de données sur ordre d’un attaquant.

Fuite de données, désinformation et actions non sollicitées

Le vrai danger : l’avènement des agents IA

Il faut bien saisir la nuance. Un chatbot classique discute, point. Un agent IA, lui, a les mains dans le cambouis : il navigue sur le web, utilise vos applis et prend des initiatives autonomes.

C’est là que ça coince. Avec ces agents conversationnels autonomes, le risque explose. Une injection de requête ne génère plus seulement du texte bizarre, elle déclenche des actions réelles et potentiellement destructrices.

Un agent IA compromis n’est plus un simple outil ; il devient une arme numérique, un cheval de Troie capable d’agir en votre nom mais sous les ordres d’un autre.

Dark GPT et les jumeaux maléfiques

Vous pensez que toutes les IA sont bienveillantes ? Détrompez-vous. Il existe des versions débridées, sans les garde-fous de sécurité habituels, qu’on appelle souvent les jumeaux maléfiques des modèles grand public.

Le pire, c’est qu’une simple injection peut pousser votre assistant docile à imiter ces jumeaux maléfiques de l’IA, contournant ses propres règles de sécurité pour exécuter des ordres toxiques.

Qui est visé ? entreprises et particuliers, même combat

Ne croyez pas être à l’abri. Tout le monde est une cible potentielle. Pour les entreprises, l’enjeu est colossal : vol de données stratégiques ou paralysie totale des systèmes informatiques.

Côté particuliers, c’est tout aussi effrayant : vol d’identité, fraude bancaire ou harcèlement. Si votre IA gère vos comptes, la vigilance sur les requêtes IA sécurité devient l’affaire de tous, sans exception.

La sécurité de l’IA : un problème qui dépasse vos requêtes

On a beaucoup parlé des requêtes, mais la sécurité d’une IA est un enjeu bien plus large. Les failles ne se situent pas uniquement au moment où vous lui parlez, mais tout au long de son cycle de vie.

Les menaces durant tout le cycle de vie de l’IA

La sécurité ne se joue pas seulement quand vous tapez une phrase. De la première ligne de code à l’utilisation finale, chaque étape est une cible potentielle pour les pirates.

| Phase du Cycle de Vie | Type de Menace | Description du Risque |

|---|---|---|

| Entraînement | Empoisonnement des données (Data Poisoning) | L’attaquant introduit des données corrompues ou biaisées dans le jeu de données d’entraînement pour créer des failles ou des comportements spécifiques dans le modèle final. |

| Déploiement | Attaque de la chaîne d’approvisionnement (Supply-chain Attack) | L’attaquant compromet un composant ou une librairie utilisée pour construire l’IA, insérant une porte dérobée (backdoor) avant même sa mise en service. |

| Production (Utilisation) | Injection de requête (Prompt Injection) | L’attaquant manipule les entrées de l’utilisateur pour détourner le comportement de l’IA et déclencher des actions non désirées. |

L’empoisonnement des données : corrompre l’IA à la source

Parlons de l’empoisonnement des données. C’est une attaque sournoise qui survient bien avant votre arrivée. Le pirate corrompt l’éducation de l’IA à la racine en injectant du faux contenu pour fausser tout son apprentissage futur.

Un modèle ainsi saboté cache des angles morts volontaires ou réagit bizarrement à des mots-clés précis. C’est une vulnérabilité invisible mais dévastatrice, prête à être exploitée n’importe quand par ceux qui connaissent la clé.

Sécurité de l’IA vs sécurité par l’IA

Ne mélangeons pas tout. La “sécurité de l’IA” vise à protéger le système IA lui-même contre les intrusions et les détournements. C’est exactement ce qui nous préoccupe ici avec les requêtes IA sécurité et leurs risques.

La “sécurité par l’IA”, c’est l’inverse. On utilise l’intelligence artificielle comme un chien de garde pour détecter les virus ou surveiller les réseaux. L’un est la cible, l’autre est l’arme de défense.

L’audit de robustesse : un passage obligé ?

Les entreprises sérieuses ne lancent pas une IA dans la nature sans filet. Elles doivent la torturer un peu avant. C’est le principe de l’audit de robustesse, souvent appelé “red teaming” par les pros.

Des équipes dédiées tentent activement de “casser” le modèle avant sa mise en ligne pour débusquer les failles. C’est une étape vitale pour tout service critique reposant sur l’intelligence artificielle, sinon c’est le crash assuré.

Quand l’IA code, la vigilance est de mise pour les développeurs

On a vu les risques pour l’utilisateur lambda, mais il y a une catégorie de professionnels pour qui les requêtes IA sécurité présentent un danger très spécifique : les développeurs.

Le code généré par IA : un gain de temps, un risque de sécurité

Utiliser des IA pour générer des blocs entiers de code est devenu la norme pour booster la productivité. C’est un gain de temps indéniable, mais cette facilité apparente ouvre malheureusement une nouvelle surface d’attaque souvent sous-estimée.

Le piège ? L’IA peut recracher du code vulnérable, des fonctions obsolètes ou, pire, intégrer des portes dérobées subtiles. Un attaquant astucieux pourrait manipuler le modèle via une injection pour compromettre votre application.

Ne jamais faire confiance aveuglément

Voici la règle d’or à graver sur votre écran : tout code issu d’une IA doit être traité comme provenant d’une source non fiable, voire hostile.

- Auditer systématiquement : Chaque ligne de code doit être relue et comprise par un humain avant d’être intégrée.

- Éviter pour le critique : Ne pas utiliser de code généré par IA pour des modules sensibles comme la cryptographie, la gestion des accès ou les transactions financières.

- Proscrire l’exécution automatique : Ne jamais mettre en place un système où le code généré par une IA est exécuté sans validation humaine intermédiaire.

L’approche DevSecOps appliquée à l’IA

Oubliez la sécurité comme simple étape de vérification finale. Le DevSecOps impose une culture où la sécurité est intégrée à chaque étape du développement, dès la première ligne de code écrite.

Appliqué à l’IA, cela signifie scanner impitoyablement le code généré avec des outils d’analyse automatisés (SAST). Il faut aussi former vos équipes aux risques spécifiques pour créer un chatbot IA performant et réellement sécurisé face aux menaces actuelles.

Le risque subtil des dépendances cachées

Il existe un vice encore plus pernicieux : les hallucinations de paquets. L’IA peut vous suggérer d’utiliser des librairies ou des dépendances peu connues, voire inexistantes, qui ont été squattées par des acteurs malveillants pour infiltrer la chaîne d’approvisionnement.

Un développeur pressé pourrait installer cette dépendance sans vérifier sa légitimité, intégrant de fait un code malveillant directement dans son projet. La vigilance sur l’origine des paquets suggérés est donc une question de survie.

Les lignes de défense : comment le secteur se protège

Face à cette menace grandissante, les concepteurs d’IA ne restent pas les bras croisés. Plusieurs stratégies de défense sont mises en place pour tenter de colmater les brèches et sécuriser les interactions.

Filtrage et blocage : la première barrière

La première ligne de défense repose sur des filtres automatisés stricts. Des systèmes avancés, comme ceux intégrés à Gemini de Google, analysent en temps réel les entrées pour détecter les requêtes IA sécurité suspectes ou les tentatives de manipulation flagrantes. C’est un tri immédiat.

Si l’algorithme identifie une activité potentiellement dangereuse ou une structure anormale, il coupe court à la conversation. L’IA peut alors simplement refuser d’utiliser le contenu incriminé pour générer sa réponse, bloquant ainsi l’attaque avant qu’elle ne produise le moindre résultat.

La validation humaine : le garde-fou ultime ?

Pour les actions les plus critiques, la technologie seule montre ses limites et ne suffit pas. Une solution efficace consiste à ne jamais laisser l’IA prendre seule une décision sensible sans qu’un opérateur humain ne valide l’opération finale.

C’est tout le principe du chatbot hybride, qui combine la puissance de calcul de l’IA et le jugement irremplaçable de l’humain. Bien sûr, cette méthode ralentit le processus global et crée de la friction, ce qui la rend difficilement applicable à grande échelle pour des tâches banales.

Une défense en profondeur, pas de solution miracle

Il faut se rendre à l’évidence : il n’existe pas de baguette magique pour sécuriser ces modèles. La protection efficace d’une IA repose obligatoirement sur une approche multi-couches, où chaque barrière compense les faiblesses de l’autre.

Se fier à un seul filtre, c’est comme fermer la porte d’entrée à clé en laissant toutes les fenêtres de la maison grandes ouvertes. La défense doit être partout.

Cette stratégie combine des filtres stricts en entrée, une surveillance continue du comportement du modèle, des limitations techniques de ses capacités et, comme vu plus haut, une validation humaine pour les actions sensibles.

La course à l’armement entre attaquants et défenseurs

C’est un véritable véritable jeu du chat et de la souris qui se joue en coulisses. Dès que les attaquants mettent au point de nouvelles techniques d’injection pour contourner les protections, les défenseurs développent de nouveaux filtres pour les contrer.

Cette course à l’armement perpétuelle signifie que la sécurité d’une IA n’est jamais totalement acquise ni définitive. Elle doit être constamment réévaluée, testée et mise à jour pour faire face à l’évolution rapide et ingénieuse des menaces.

Votre rôle dans l’équation : comment utiliser l’IA en sécurité

Les développeurs blindent leurs modèles, c’est un fait. Mais en bout de chaîne, vous n’êtes pas impuissant, bien au contraire. Adopter quelques réflexes de bon sens suffit souvent à réduire drastiquement les risques.

La prudence, votre meilleure alliée

La règle d’or tient en un mot : scepticisme. C’est capital, surtout lorsque vous manipulez des requêtes IA sécurité impliquant du contenu extérieur. Si l’information ne vient pas de vous ou d’une source fiable à 100 %, la méfiance s’impose.

Soyez paranoïaque avec les e-mails contenant des pièces jointes ou les documents partagés via le cloud par des inconnus. Un lien vous semble louche ? Ne le soumettez surtout pas à une IA. Le risque d’injection indirecte est bien trop élevé.

Les bons réflexes à adopter au quotidien

Pas besoin d’un diplôme en cybersécurité. Voici des actions concrètes et immédiates pour verrouiller votre usage.

- Écoutez les avertissements : Si Gmail ou Drive marquent un contenu comme suspect, stop. Ne demandez surtout pas à l’IA d’analyser ce fichier.

- Ne cliquez pas aveuglément : L’IA vous génère un lien ? Survolez-le toujours pour vérifier la destination réelle avant de cliquer dessus.

- Signalez les comportements étranges : Une réponse semble bizarre, fausse ou déplacée ? Utilisez la fonction “Signaler”. C’est le meilleur moyen d’aider les filtres à s’améliorer.

- Séparez les contextes : Évitez d’utiliser une IA connectée à vos comptes professionnels pour traiter des données personnelles, et inversement. Cloisonnez tout.

Vérifiez les réponses, surtout les plus importantes

Gardez en tête que même les modèles les plus pointus, y compris les meilleures IA de 2026, peuvent dérailler ou être manipulés. Elles ne sont pas infaillibles. Ce qu’elles racontent n’est jamais parole d’évangile, loin de là.

Pour toute information financière, médicale ou professionnelle, croisez toujours vos sources. Ne prenez jamais une décision critique. Ce serait jouer avec le feu sans filet de sécurité.

S’informer pour mieux se protéger

L’éducation reste votre meilleur pare-feu. Comprendre les failles potentielles de l’IA conversationnelle est la première marche indispensable pour s’en prémunir efficacement. Sans cette conscience du risque, on navigue littéralement à l’aveugle.

La technologie galope, et les méthodes des attaquants s’adaptent à toute vitesse. Rester informé des nouvelles menaces est un effort continu, pas une option. Au final, votre vigilance reste votre atout maître face aux pièges.

L’IA est un allié puissant, mais elle n’est pas immunisée contre les manipulations comme l’injection de requête. Restez vigilant face aux contenus inconnus et ne validez rien les yeux fermés. La technologie évolue, mais votre bon sens reste le meilleur antivirus. Après tout, c’est vous le chef, pas l’algorithme !